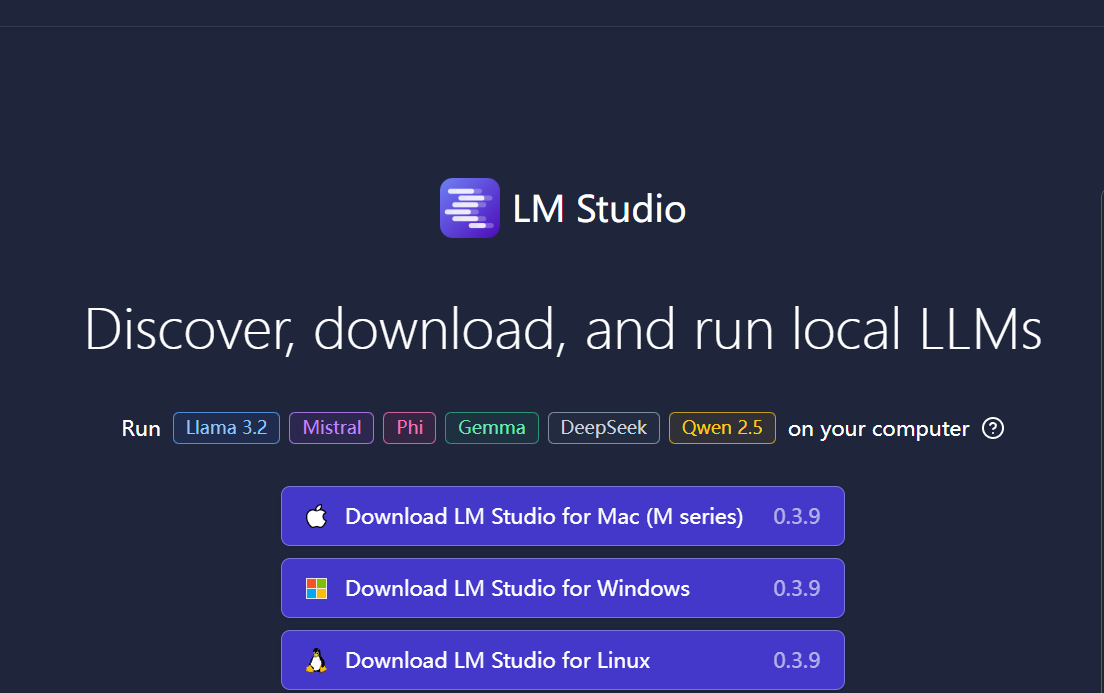

在780M核显笔记本上通过LM Studio本地化部署DeepSeek大模型

本来想用Ollama部署LLM,但我下载启动Ollama后发现官方不支持我的Radeon 780M核显(gfx1103): 123456789101112C:\Users\lincannm>ollama serve2025/02/01 18:01:29 routes.go:1187: INFO server config env="map[CUDA_VISIBLE_DEVICES: GPU_DEVICE_ORDINAL: HIP_VISIBLE_DEVICES: HSA_OVERRID...